-

生物通官微

陪你抓住生命科技

跳动的脉搏

面向自动驾驶实验室过程异常检测的多模态视觉数据集构建与分析

《Scientific Data》:A Visual Dataset for Anomaly Detection in Self-Driving Laboratories

【字体: 大 中 小 】 时间:2025年11月16日 来源:Scientific Data 6.9

编辑推荐:

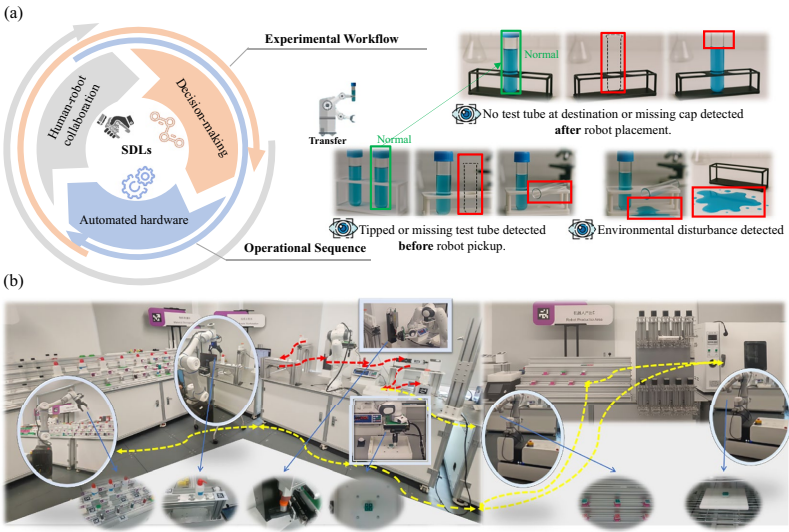

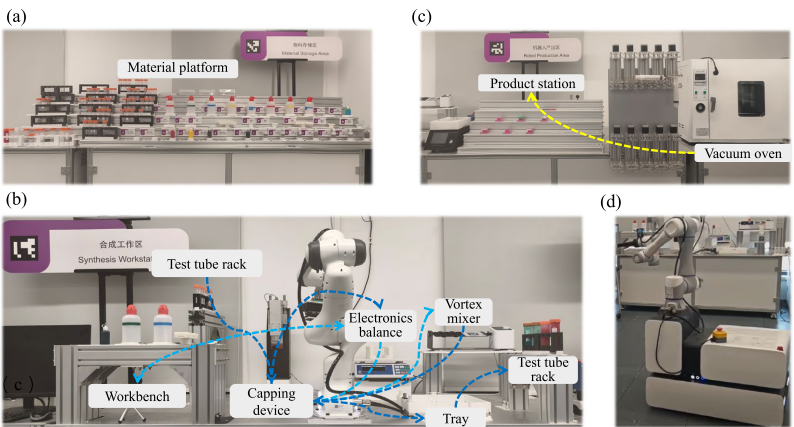

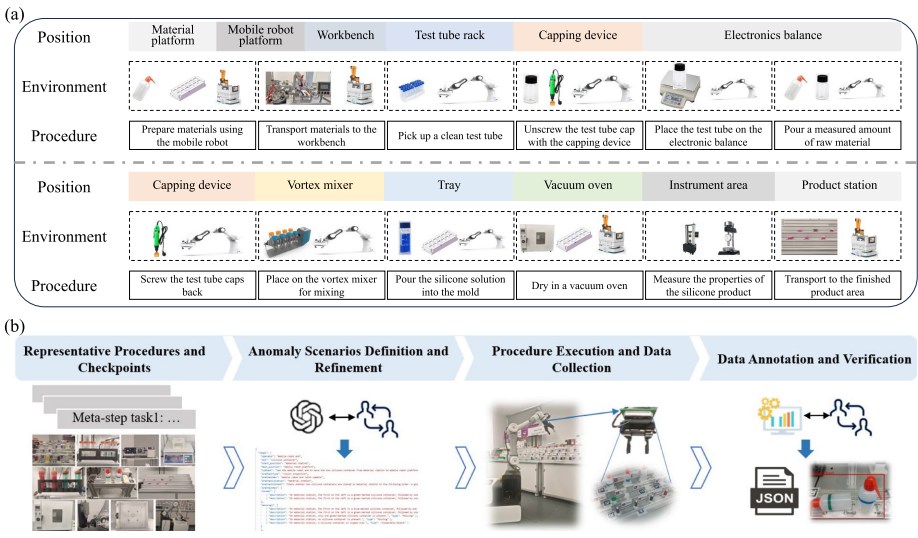

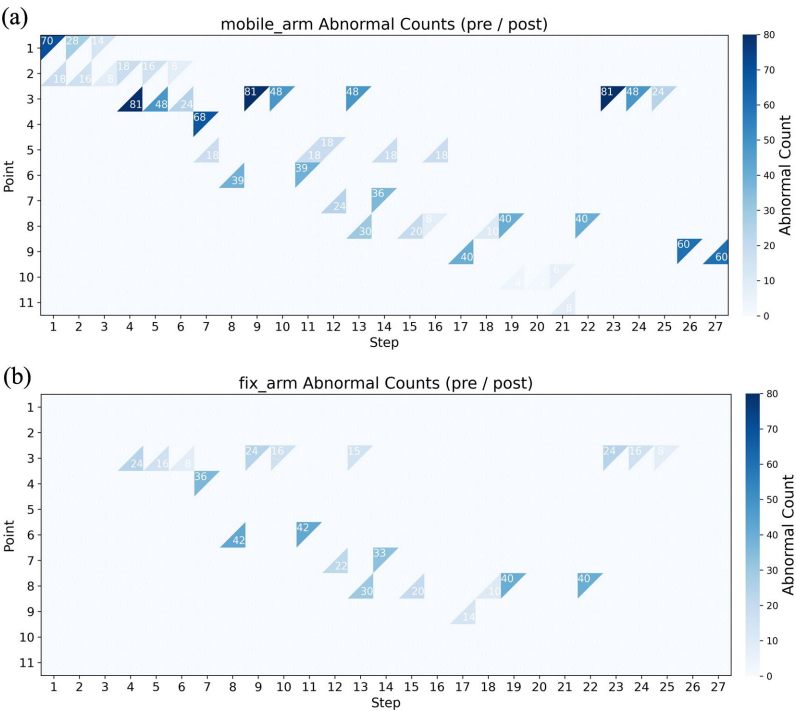

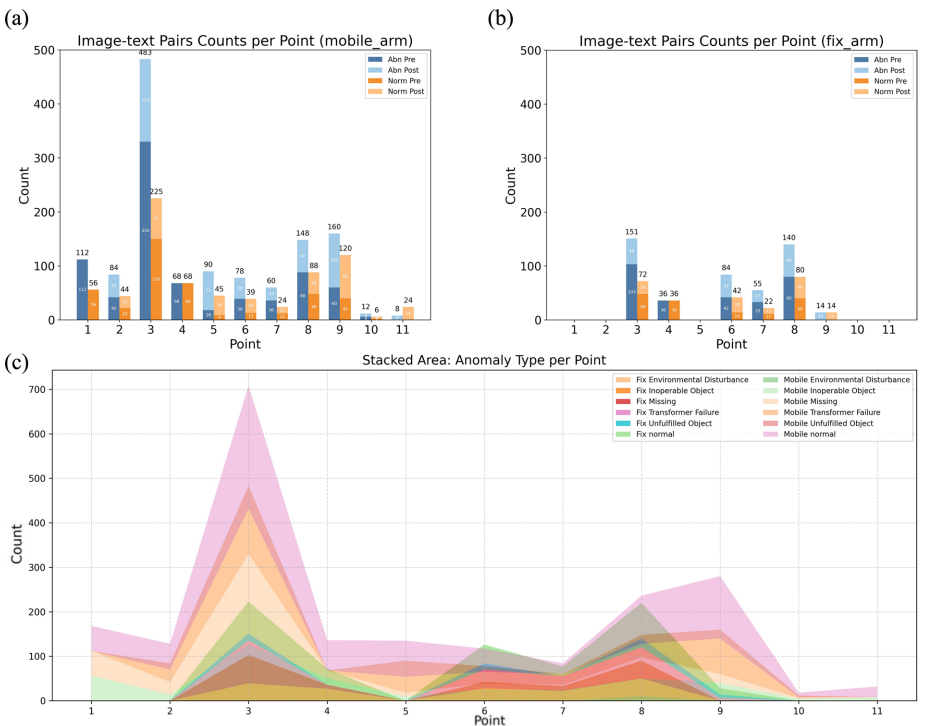

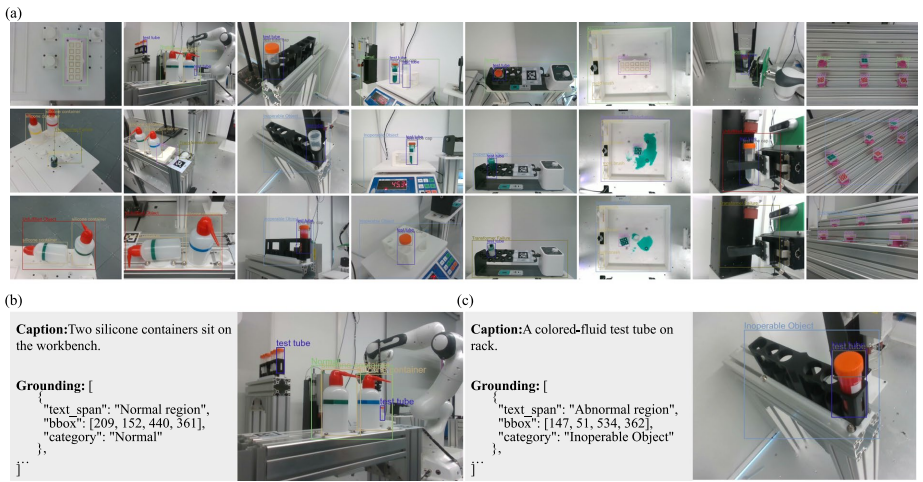

本刊推荐:为解决自动驾驶实验室(SDLs)中因过程不确定性和环境复杂性导致的异常检测难题,研究团队开展了基于第一人称视觉的异常检测数据集构建研究。该研究通过机械臂末端执行器摄像头采集了11个检查点、14个视角的1,671张图像和2,788个图文对,建立了包含五类异常标签的区域级标注体系。该数据集为视觉语言模型在实验过程异常监控、定位和归因分析任务提供了重要资源,对推动智能实验室安全运维具有显著意义。

生物通微信公众号

生物通微信公众号

知名企业招聘