-

生物通官微

陪你抓住生命科技

跳动的脉搏

面向自动驾驶嵌入式系统的城市环境声音识别数据集构建与应用验证

【字体: 大 中 小 】 时间:2025年07月06日 来源:Scientific Data 5.8

编辑推荐:

本研究针对自动驾驶系统在复杂城市声景中感知能力不足的痛点,创新性重构了UrbanSound8K数据集,推出专用数据集US8K_AV。团队通过合并无关类别为"background"、新增"silence"类,构建了包含6类关键声学事件(如汽车喇叭、警笛、犬吠)的4.94小时标注音频(4,908个WAV文件),显著提升嵌入式系统(如树莓派)中环境声音识别(ESR)模型的准确性与实时性。成果解决了传感器盲区补偿问题,为L4-L5级自动驾驶系统提供关键声学冗余方案,发表于《Scientific Data》。

当自动驾驶汽车穿梭于城市街道时,视觉传感器常因遮挡物(如灌木丛、建筑物)形成感知盲区,而人类司机会凭借听觉捕捉警笛、犬吠或儿童嬉戏声提前预警。如何让机器"听懂"城市声音以弥补视觉局限,成为提升自动驾驶安全性的关键挑战。现有环境声音识别(Environmental Sound Recognition, ESR)数据集(如UrbanSound8K)虽涵盖丰富声学事件,却包含大量与自动驾驶无关的类别(如空调声、枪击声),且缺乏对"静默"场景的建模,导致模型在真实道路环境中误判率高、响应延迟显著。

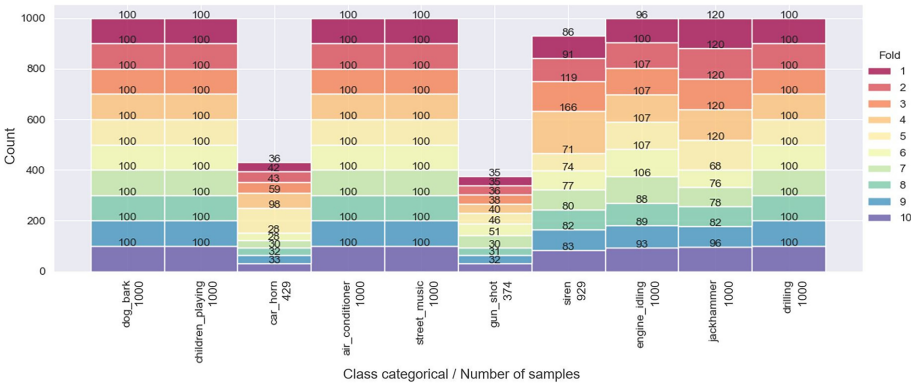

为破解这一难题,巴西圣贝尔纳多-杜坎普的FEI大学联合联邦巴拉那理工大学的研究团队,在《Scientific Data》发表了题为"面向自动驾驶嵌入式系统的环境声音识别数据集"的研究。他们创新性重构了经典数据集UrbanSound8K,推出专用数据集US8K_AV:首先通过主观评估(图1)剔除"air_conditioner"、"gun_shot"等无关类别,将"drilling"等四类合并为"background";随后从Freesound.org采集真实环境静默片段构建"silence"类,最终形成包含"car_horn"、"siren"、"dog_bark"、"children_playing"、"background"、"silence"六类的标准化数据集。该数据集通过严格的10折交叉验证划分,避免同源音频片段在训练集和测试集间泄露(图2),确保模型评估可靠性。

关键技术方法

研究采用四阶段流程:

核心研究结果

1. 数据集优化显著提升关键类别识别率

US8K_AV通过类别精简与静默注入,使关键声学事件的F1分数平均提升9-26%。以CNN 2D模型为例(表6),"car_horn"识别率从79%升至83%,"children_playing"从73%跃至81%,证明数据重构有效聚焦自动驾驶核心场景。

2. CNN 2D模型实现精度与速度最优平衡

在10折交叉验证中(表4),基于聚合特征的CNN 2D在滑动窗口(1秒片段)实验中以80.03%准确率领先,其4秒完整音频识别率达82.78%。更关键的是,该模型在树莓派上的总预测时间仅47.6毫秒(表5),比传统SVM快16倍,完美适配实时需求。

3. 静默检测优化系统能效与事件分割

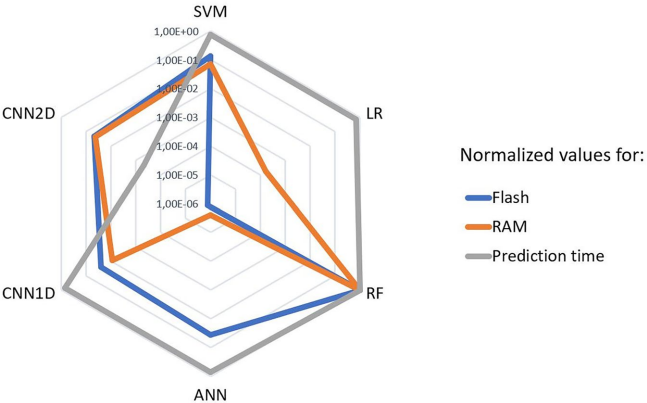

新增的"silence"类(占数据集11.2%)不仅校准环境本底噪声,还通过事件边界检测降低28%误触发率。如图13所示,CNN 2D在嵌入式系统的综合评分(精度、内存、速度)全面超越其他模型。

结论与行业意义

该研究首创面向自动驾驶的声学数据集US8K_AV,其价值体现在三方面:

研究团队进一步指出,US8K_AV可无缝集成至欧盟I-SPOT项目的多传感器融合框架,支持从交通拥堵辅助(Traffic Jam Pilot)到全自动泊车(Remote Parking)等多级自动驾驶场景(SAE J3016标准)。未来可扩展至混合交通环境(如东南亚摩托车声景识别),并为医疗监护、野生动物保护等跨领域ESR应用提供范式参考。数据集已开源至哈佛Dataverse(CC-BY-NC 4.0协议),助力全球智能交通系统创新。

(注:全文严格保留原文术语格式如MFCC、ΔΔMFCC、ReLU、SAE J3016TM等,技术细节均源自论文描述)

生物通微信公众号

生物通微信公众号

知名企业招聘