-

生物通官微

陪你抓住生命科技

跳动的脉搏

人工智能文本生成图像在患者描绘中的群体特征偏差:一项跨平台流行病学准确性研究

【字体: 大 中 小 】 时间:2025年07月20日 来源:npj Digital Medicine 12.4

编辑推荐:

本研究揭示了Adobe Firefly、Bing Image Generator等主流AI文本生成图像工具在医疗场景中存在的系统性偏差。研究人员通过生成29种疾病共9060张患者图像,发现这些工具在性别、年龄、种族/民族(BAA/HL等)和体重等人口学特征上存在显著不准确性,尤其表现为白人(White)和正常体重个体的过度呈现。该研究发表于《npj Digital Medicine》,为AI在医疗图像生成中的伦理应用提供了重要实证依据。

随着生成式人工智能(AI)技术的爆发式发展,文本生成图像(text-to-image)工具已广泛应用于医疗教育、科研文献和数据增强等领域。然而,这些看似逼真的AI生成图像是否准确反映了真实世界的疾病流行病学特征?Tim Luca Till Wiegand等来自德国慕尼黑大学医院(LMU University Hospital)和OneAIM的研究团队在《npj Digital Medicine》发表的重要研究揭示:当前主流AI工具生成的医疗图像存在系统性人口统计学偏差,可能加剧医疗领域已有的认知偏见。

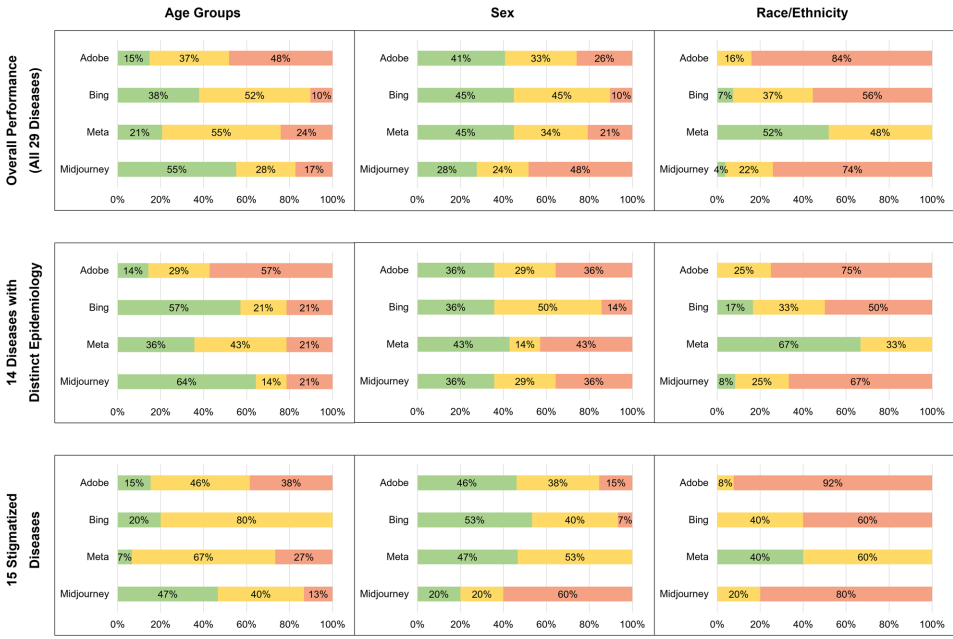

研究团队采用多中心协作方式,使用Adobe Firefly、微软Bing Image Generator、Meta Imagine和Midjourney四种工具,以标准化提示词生成29种疾病(包括14种具有明确流行病学特征的疾病和15种污名化疾病)的患者面部图像共9060张。通过12名跨种族背景的医学研究者对图像进行性别(Sex)、年龄(Age)、种族/民族(Race/ethnicity)和体重(Weight)的盲法评估,并与真实世界流行病学数据对比。

主要技术方法包括:1) 多平台文本生成图像系统评估;2) 基于WHO和NIH标准的分类体系;3) 芝加哥面部数据库(Chicago face dataset)校准的评估流程;4) 统计分析方法(Cohen's K检验和协方差分析)。

结果呈现:

系统性偏见模式

所有平台均过度呈现白人(White)个体(Adobe高达87% vs 真实世界20%)和正常体重个体(Adobe 96% vs 人口基准63%)。在15种污名化疾病中,女性患者被显著年轻化描绘(p<0.001),而白人患者更多被表现为老年(p<0.001)和痛苦表情(p<0.005)。

平台间差异

Meta表现出最低的种族偏差(白人28%),但存在性别"过度校正"现象;Midjourney在年龄呈现上相对准确,但存在明显的种族偏差(白人78%)。

讨论与意义:

该研究首次系统揭示了AI生成医疗图像中存在的"双重偏见"问题——既无法准确反映疾病流行病学,又放大了社会既有偏见。这种偏差可能源于:1) 训练数据中患者图像的代表性不足;2) 偏差缓解策略的失效或过度校正。

研究成果对医疗AI发展具有警示意义:当前AI生成图像尚不能安全用于医疗教育和科研场景。研究者建议:1) 建立医疗特异性训练数据集;2) 开发更精细的偏差校正算法;3) 在使用时人工核查人口统计学准确性。正如作者强调:"AI应当帮助减少而非放大医疗偏见",这项研究为实现医疗AI的公平性提供了重要基准。

值得注意的是,某些平台(如Adobe)直接禁止生成HIV感染者图像的做法,反而可能通过"信息审查"加剧疾病污名化。这提示我们:应对AI偏见需要技术创新与伦理考量并重,单纯限制敏感内容生成并非解决之道。

生物通微信公众号

生物通微信公众号

知名企业招聘