-

生物通官微

陪你抓住生命科技

跳动的脉搏

医疗人工智能实施与审查的公平框架(FAIR-AI):构建安全创新的医疗AI治理新范式

【字体: 大 中 小 】 时间:2025年08月13日 来源:npj Digital Medicine 15.1

编辑推荐:

本刊推荐:为解决医疗AI快速部署与安全监管间的矛盾,研究团队通过文献综述、利益相关者访谈和多学科研讨会,开发了FAIR-AI框架。该框架提供预实施评估与后实施监测的标准化流程,包含风险筛查、深度审查和安全计划三大模块,为医疗机构平衡AI创新与患者安全提供可操作性指南。

随着人工智能(AI)在医疗领域的爆发式增长,医疗机构正面临创新与安全的双重挑战。从预测模型到生成式AI,这些技术虽能提升诊疗效率,但若缺乏严格监管,可能加剧医疗不平等、造成资源浪费甚至直接危害患者。当前欧盟AI法案和美国FDA指南等监管体系存在两大痛点:一是对"高风险"定义模糊,二是缺乏具体实施路径。这种监管真空使得医疗机构在引入AI时如履薄冰——既怕错失技术红利,又担心引发伦理危机。

为解决这一困境,由美国Advocate Health等机构组成的FAIR-AI联盟开展了开创性研究。团队通过三管齐下的方法构建了医疗AI治理新框架:首先系统梳理TRIPOD-AI等国际标准,提炼出有效性、实用性和公平性三大评估维度;随后访谈23位涵盖医院管理者、开发者、医生和患者的利益相关者,揭示出风险容忍度、人类监督等核心诉求;最终通过33位多学科专家的设计研讨会,将理论框架转化为可操作的审查工具。这项具有里程碑意义的研究成果发表于《npj Digital Medicine》。

研究采用混合方法学:通过叙事性文献综述分析42篇权威指南,采用ATLAS.ti软件对访谈录音进行主题编码,并运用共识决策法整合专家意见。特别关注PROGRESS-Plus框架中的社会决定因素,确保算法公平性评估覆盖种族、性别等9大敏感维度。

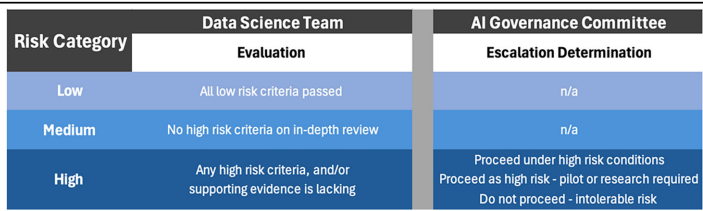

风险分类体系

创新性地提出三级风险漏斗模型:低风险工具(如行政自动化)仅需通过10项筛查问题;中高风险方案需接受16项深度审查,重点评估临床效用(Net Benefit)和校准度(F-score)。研究显示50%的AI申请可通过快速通道审批,大幅提升监管效率。

安全实施计划

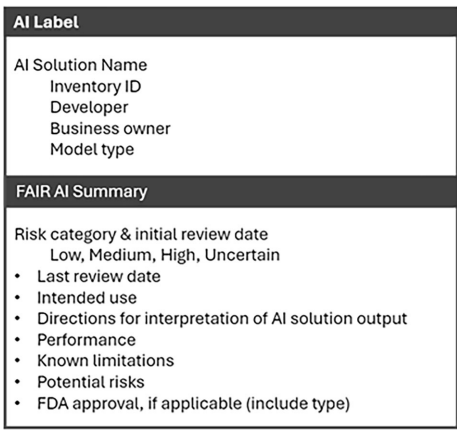

要求所有中高风险AI配备"AI标签"

动态监测机制

建立首个AI解决方案库存目录,要求业务主每季度提交使用 attestation。对涉及生命末期护理等敏感场景的AI,实施亚组分析确保不同种族患者间的AUC差异<0.05。

这项研究开创性地将理论原则转化为可执行的工作流程,其提出的风险分类树

该框架的深远意义在于:首次系统整合了技术验证(TRIPOD)、伦理审查(PROGRESS-Plus)和运营监控三大维度,为医疗机构构建了端到端的AI治理基础设施。随着FDA将FAIR-AI核心要素纳入新版SaMD指南,这一框架有望成为全球医疗AI监管的新基准,在技术创新与患者安全间实现微妙平衡。

生物通微信公众号

生物通微信公众号

知名企业招聘